Virus “inventati” dall’IA… una nuova soglia

Accorciando sempre di più la distanza tra fantascienza e realtà, l’intelligenza artificiale sta rivoluzionando molti settori, dalla diagnostica medica alla produzione industriale.

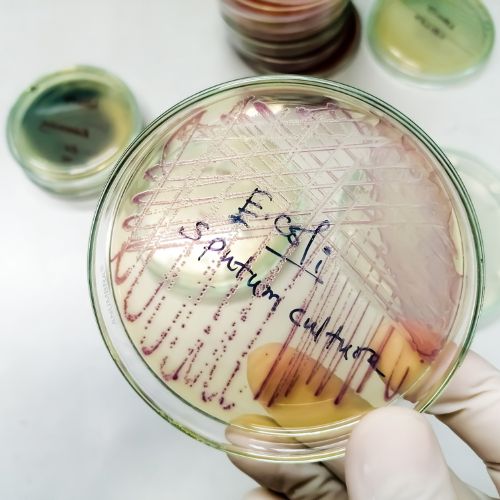

La notizia più recente, a cui la rivista Nature dedica l’apertura del proprio sito web[1], riguarda un confine che fino a ieri sembrava esclusivamente teorico: ricercatori americani guidati da Brian Hie e Samuel King hanno prodotto i primi virus progettati interamente da un’IA, capaci di attaccare ceppi resistenti del batterio Escherichia coli. Tale studio, pubblicato come preprint su bioRxiv il 17 settembre 2025[2], racconta le tappe essenziali del progetto: modelli chiamati Evo 1 ed Evo 2 addestrati su oltre due milioni di genomi di batteriofagi; da un template genico — il virus ?X174 con i suoi 5.386 nucleotidi e 11 geni — l’IA ha appreso struttura e funzionalità virali, generando migliaia di possibili sequenze e selezionandone 302 da sintetizzare. Di questi, 16 si sono comportati come veri batteriofagi: infettare, replicarsi, e persino uccidere ceppi di E. coli che il virus naturale ?X174 non riusciva ad attaccare[3]. In sostanza, l’IA non si è limitata a simulare varianti geniche: ha concepito “nuovi” virus con attività biologiche funzionali. Quanti batteri farmaco-resistenti potrebbero essere combattuti da virus su misura? E, contemporaneamente, quali rischi stiamo abbassando? Prima di addentrarci nei pericoli, è giusto riconoscere le potenzialità rivoluzionarie che si aprono. Una delle più promettenti riguarda le terapie antivirali e batteriofagiche personalizzate: si può immaginare così una medicina in cui, invece di combattere le infezioni con antibiotici generici, vengano prodotti virus “buoni” progettati su misura per distruggere specifici ceppi resistenti. In questo scenario l’IA accelera la scoperta di virus ottimizzati, riducendo drasticamente tempi e costi rispetto all’approccio tradizionale. Un altro campo riguarda l’ottimizzazione biologica in ambiti diversi dalla medicina, dall’agricoltura alla produzione di biomateriali, dai biosensori alla biomanifattura. La capacità dell’IA di esplorare spazi genetici immensi consente di immaginare microrganismi progettati per degradare rifiuti, sintetizzare composti chimici, o produrre biocarburanti in modo molto più efficiente rispetto alle tecniche odierne. Non meno importante è la accelerazione della ricerca biologica resa possibile dall’IA, che riduce sensibilmente il ciclo “design-build-test-learn” – progettare, costruire, testare, apprendere – permettendo di iterare esperimenti in tempi rapidissimi. Secondo studi recenti, questa convergenza tra intelligenza artificiale e biologia sintetica, definita “SynBioAI”, ha la forza di democratizzare l’ingegneria biologica, pur lasciando aperta la questione della sicurezza e dei rischi correlati. Infine, non va dimenticato il ruolo dello scouting preventivo. Lo stesso strumento che potrebbe generare virus pericolosi può infatti essere usato per simulare versioni virtuali di patogeni potenziali e permettere alla sanità pubblica di preparare in anticipo contromisure e vaccini “anticipatori”. È una funzione che rovescia la prospettiva: ciò che appare come minaccia diventa anche strumento di difesa, in grado di aumentare la resilienza collettiva. La scoperta di virus progettati da IA non è soltanto un traguardo tecnico: è un campanello d’allarme per quelli che fino a ieri erano considerati limiti improbabili. Ogni tecnologia biologica ha natura doppia e porta con sé il rischio del dual-use e del bioterrorismo[4]: gli stessi strumenti che possono curare possono anche diventare armi. L’IA abbassa la soglia tecnica per progettare agenti patogeni “su misura” – con maggiore patogenicità, trasmissibilità e resistenza – aprendo spiragli a usi malevoli. Un rapporto della NTI (Nuclear Threat Initiative) avverte che le capacità dell’IA per la biologia potrebbero rendere possibile la sintesi di patogeni più pericolosi di quelli conosciuti, se non accompagnate da regole e controlli rigorosi. Non a caso, alcuni modelli di IA attuali (come versioni avanzate di Llama, ChatGPT o Claude) potrebbero già fornire istruzioni dettagliate per ricostruire virus da DNA sintetico, o per introdurre mutazioni capaci di aumentarne la letalità, mettendo in discussione l’idea che la complessità della biologia sia di per sé una barriera protettiva. A ciò si aggiunge il pericolo di errori, fughe accidentali e laboratori mal gestiti: non serve un attacco deliberato, bastano incidenti di biocontenimento, contaminazioni o malfunzionamenti. La storia insegna che anche nei laboratori di massima sicurezza (Biosafety Level 4) non sono mancati episodi critici; e con la democratizzazione degli strumenti, più istituti e centri di ricerca avranno accesso a tecnologie avanzate senza disporre sempre della stessa cultura del rischio, o degli stessi standard di governance. C’è poi la suggestiva e inquietante possibilità di evasione delle difese immunitarie e “mirror life”. Alcuni ricercatori paventano la creazione di organismi specchio, costruiti con una struttura molecolare invertita rispetto a quella tipica della vita naturale: molecole non riconoscibili dal nostro sistema immunitario e quindi potenzialmente in grado di eludere ogni difesa o trattamento. Se fino a poco tempo fa questo scenario apparteneva alla fantascienza, oggi entra con forza nel dibattito scientifico, tanto che gruppi internazionali hanno chiesto una moratoria sulla ricerca in quest’area per evitare derive catastrofiche. Ma non basta: le attuali regole appaiono obsolete e la governance inadeguata. Le normative bioetiche internazionali, dalla Biological Weapons Convention alle linee guida di biosecurity, non riescono a tenere il passo del ritmo dell’innovazione. Studiosi come Nik Hynek hanno sottolineato che il vero problema non è la tecnologia in sé, ma la mancanza di meccanismi trasparenti su chi decide cosa rendere pubblico, chi può accedere agli strumenti e come tracciare le sequenze più sensibili. Una recente analisi su modelli fondativi di IA sostiene che le stime ufficiali stanno minimizzando i rischi, sottovalutando l’effetto amplificatore che questi strumenti possono avere nelle mani di attori malintenzionati. Infine, si apre il capitolo della corsa globale e delle disuguaglianze nell’accesso. Chi controlla l’IA applicata alla biologia deterrà anche una forma inedita di potere geopolitico: potrà decidere quali tecnologie distribuire e quali bloccare, quali terapie sviluppare e quali ritardare. In scenari più oscuri, potremmo assistere a una corsa segreta tra Stati e gruppi non regolati, alla ricerca di un vantaggio biotecnologico che rischia di trasformare l’IA in una nuova arma di supremazia. Per ampliare lo sguardo e stimolare visioni critiche, vale la pena interrogarsi su alcune immagini del futuro che emergono da questa nuova frontiera. La prima riguarda la soglia di “vita artificiale”: se un’IA riesce a progettare un virus capace di replicarsi efficacemente, siamo vicini al momento in cui ciò che definiamo “vita” potrà essere scritto su misura. Il confine fra ingegneria e creazione rischia così di sfumare. In parallelo, i virus come farmaco o come minaccia duale delineano uno scenario ambivalente: da un lato, in futuro potremmo immaginare “cocktail virali terapeutici” composti da più virus progettati da IA, ciascuno mirato a un ceppo specifico con controllo genotipico accurato; dall’altro lato, la stessa tecnica potrebbe essere piegata a fini offensivi. Un ulteriore punto delicato è quello dei modelli autonomi di IA che evolvono esperimenti invisibili: potremmo arrivare a sistemi in grado di gestire intere pipeline sperimentali senza supervisione umana costante, ottimizzando sequenze in modalità “black box” (trattate o utilizzate senza che se ne conosca a fondo il funzionamento interno o la logica che le genera). Se ciò avvenisse con virus, il rischio di evoluzioni impreviste diventerebbe concreto e difficilmente governabile. Di fronte a questi scenari, si profila la necessità di sistemi di sorveglianza: veri e propri “firewall biologici” in grado di monitorare la sintesi del DNA, verificare sequenze virali, attivare “tripwire” (cioè delle soglie sensibili in grado di segnalare anomalie genetiche) e mettere in campo in tempo reale controlli in silico (effettuati cioè con software di calcolo e simulazione) anziché in vitro (in provetta) o in vivo (su organismi viventi). Ma la domanda rimane: chi controllerà i controllori? Chi cioè vigilerà su un’etica scientifica e una cultura del “non male”? I ricercatori del futuro dovranno sviluppare non solo competenze tecniche, ma anche la capacità di riconoscere candidati virali troppo rischiosi, rifiutare esperimenti anche se fattibili e costruire percorsi di trasparenza condivisa.

Infine, emerge il tema della cooperazione internazionale “biologica”. Così come esiste un G-20 economico o nucleare, sarà necessario creare un organismo multilaterale capace di occuparsi di “disarmo genetico controllato”, con poteri di stabilire soglie, condurre verifiche e imporre sanzioni per l’uso incontrollato dell’IA applicata alla biologia. Solo un simile patto globale potrà garantire che la nuova soglia varcata dall’intelligenza artificiale resti un’occasione di progresso e non una minaccia per l’umanità. Siamo in un momento in cui la tecnologia azzera distanze che fino a ieri erano considerate invalicabili: queste soglie richiedono non solo meraviglia, ma anche allerta. Non si tratta di demonizzare l’IA, ma di assumersi responsabilità: investire in regolamentazione, cultura della sicurezza, trasparenza e governance globale. Perché chi imprigiona il fuoco non è solo chi lo spegne, ma anche chi pone le condizioni che impediscono l’incendio. E dunque: quale nuovo patto tra scienza, etica e potere stiamo per firmare?

IMMAGINE: iStock/Md Saiful Islam Khan

[1] https://www.nature.com/articles/d41586-025-03055-y

[2] https://www.biorxiv.org/content/10.1101/2025.09.12.675911v1

[3] https://www.infodata.ilsole24ore.com/2025/09/27/cosa-sappiamo-sui-primi-virus-progettati-con-lintelligenza-artificiale/

[4] https://www.nti.org/about/programs-projects/project/reducing-risks-at-the-convergence-of-artificial-intelligence-and-the-life-sciences/